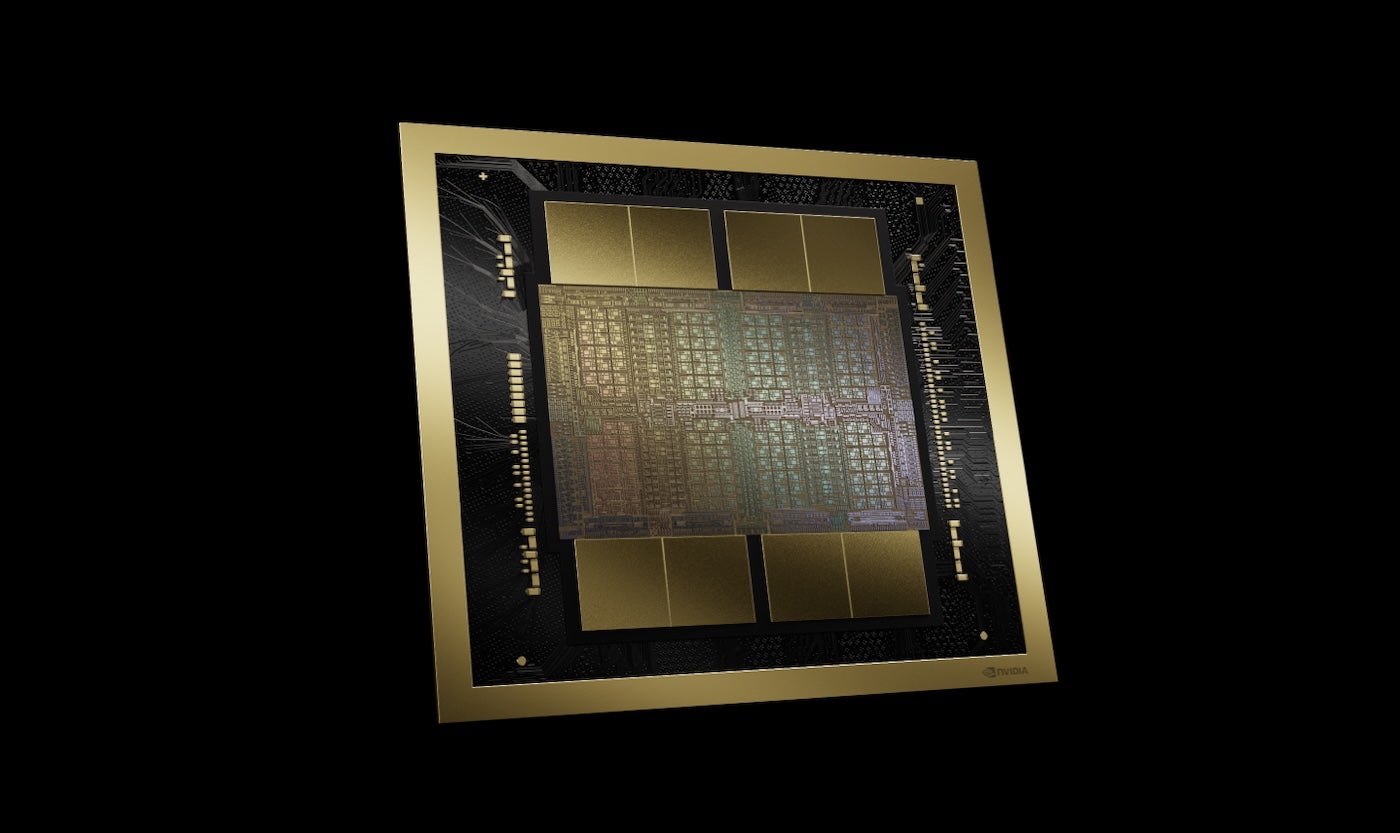

NVIDIA 最新的 GPU 平台是 Blackwell (图A),包括 AWS、微软和谷歌在内的公司计划采用该技术来实现生成式 AI 和其他现代计算任务,NVIDIA 首席执行官黄仁勋在 3 月 18 日于加州圣何塞举行的 NVIDIA GTC 大会主题演讲中宣布了这一消息。

图A

基于 Blackwell 的产品将于 2024 年底由 NVIDIA 全球合作伙伴推向市场。黄仁勋宣布了 NVIDIA 及其合作伙伴将推出的一系列其他技术和服务,他谈到生成式人工智能只是加速计算的一个方面。

“当你加速时,你的基础设施就是 CUDA GPU,”黄仁勋表示,他指的是 NVIDIA 的并行计算平台和编程模型 CUDA。“当这种情况发生时,它与生成式 AI 的基础设施相同。”

Blackwell 支持大型语言模型训练和推理

Blackwell GPU 平台包含两个芯片,通过每秒 10 TB 的芯片间互连连接,这意味着每一侧都可以像“两个芯片认为是一个芯片”一样工作,黄仁勋说道。它拥有 2080 亿个晶体管,采用 NVIDIA 的 2080 亿 4NP TSMC 工艺制造。它拥有 8 TB/S 内存带宽和 20 pentaFLOPS 的 AI 性能。

NVIDIA 表示,对于企业而言,这意味着 Blackwell 可以对高达 10 万亿个参数的 AI 模型进行训练和推理。

Blackwell 采用了以下技术:

- TensorRT-LLM 和 NeMo Megatron 的第二代产品,均来自 NVIDIA。

- 与第一代变压器引擎相比,计算和模型大小增加了一倍的框架。

- 采用本机接口加密协议进行机密计算,确保隐私和安全。

- 用于加速数据分析和数据科学中的数据库查询的专用解压缩引擎。

关于安全性,黄仁勋表示,可靠性引擎“会对 Blackwell 芯片上的每一位内存以及与其相连的所有内存进行自我测试,即系统内测试。就好像我们在发货时附带了 Blackwell 芯片的测试仪一样。”

基于 Blackwell 的产品将由合作云服务提供商、NVIDIA 云合作伙伴计划公司和精选主权云。

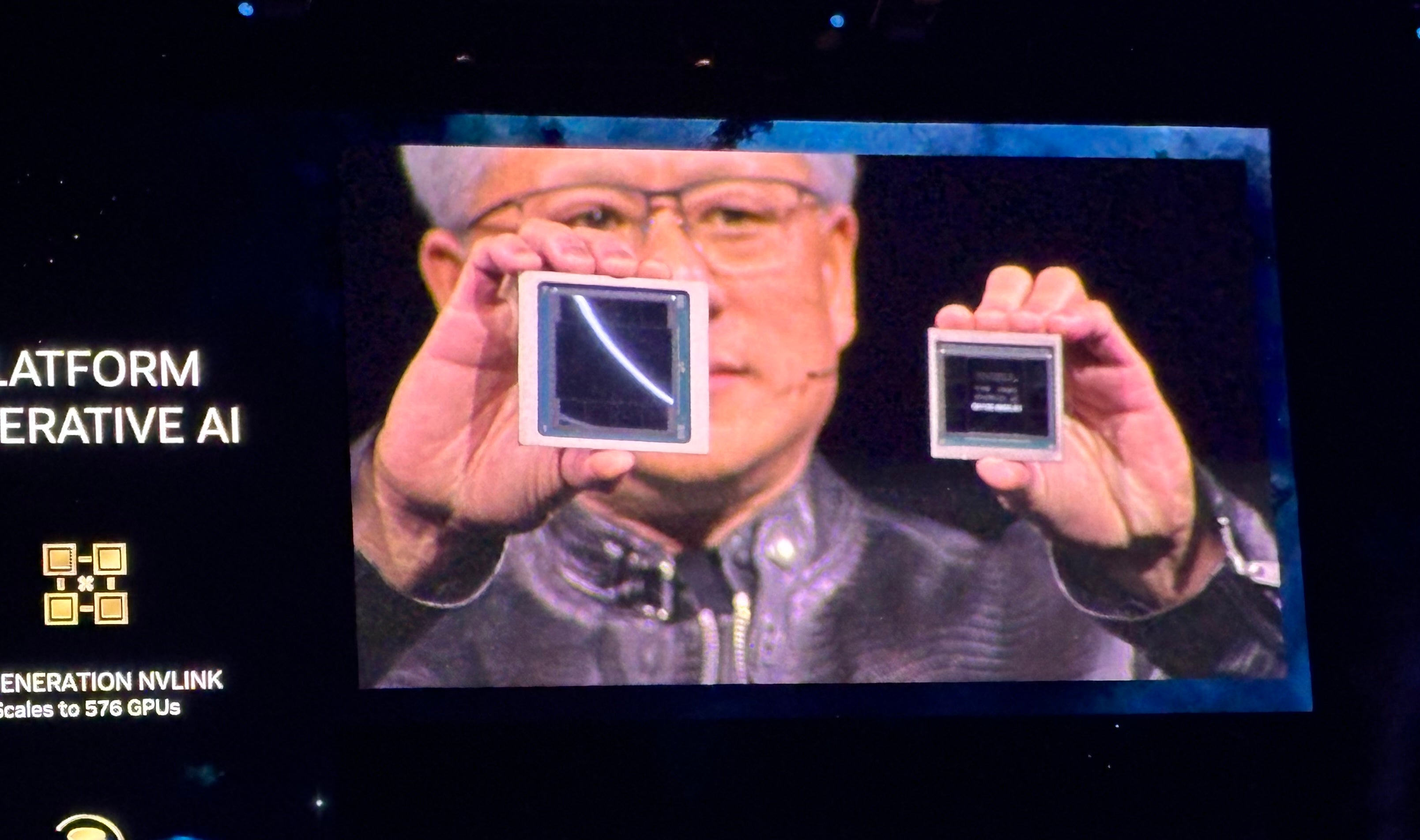

Blackwell 系列 GPU 延续了 Grace Hopper 系列 GPU 的风格,后者于 2022 年首次亮相(图B)。NVIDIA 表示,Blackwell 将在万亿参数 LLM 上运行实时生成 AI,成本和能耗比 Hopper 系列低 25 倍。

图B

NVIDIA GB200 Grace Blackwell 超级芯片连接多个 Blackwell GPU

除了 Blackwell GPU,该公司还发布了 NVIDIA GB200 Grace Blackwell 超级芯片,该芯片将两个 NVIDIA B200 Tensor Core GPU 连接到 NVIDIA Grace CPU —— 为 LLM 推理提供了一个新的组合平台。NVIDIA GB200 Grace Blackwell 超级芯片可以与该公司新发布的 NVIDIA Quantum-X800 InfiniBand 和 Spectrum-X800 以太网平台连接,速度高达 800 GB/S。

GB200 将于今年晚些时候在 NVIDIA DGX Cloud 以及 AWS、Google Cloud 和 Oracle Cloud Infrastructure 实例上推出。

新的服务器设计着眼于万亿参数人工智能模型

GB200 是新发布的 GB200 NVL72 的一个组件,这是一种机架级服务器设计,将 36 个 Grace CPU 和 72 个 Blackwell GPU 封装在一起,实现 1.8 exaFLOPs 的 AI 性能。NVIDIA 正在展望大规模、万亿参数 LLM 的可能用例,包括对话的持久内存、复杂的科学应用程序和多模式模型。

GB200 NVL72 结合了第五代 NVLink 连接器(5,000 根 NVLink 电缆)和 GB200 Grace Blackwell 超级芯片,实现了海量的计算能力,黄仁勋称之为“单个机架中的每秒千万亿次浮点运算的 AI 系统”。

“这超过了互联网的平均带宽——我们基本上可以将所有东西发送给任何人,”黄仁勋说。

黄仁勋表示:“我们的目标是不断降低计算的成本和能耗——它们是直接相关的。”

冷却 GB200 NVL72 每秒需要两升水。

下一代 NVLink 带来加速数据中心架构

第五代 NVLink 可在最多 576 个 GPU 之间提供 1.8TB/s 的双向吞吐量。此 NVLink 迭代旨在用于当今最强大的复杂 LLM。

黄仁勋表示:“未来,数据中心将被视为人工智能工厂。”

NVIDIA 推理微服务简介

可能的“AI工厂”的另一个元素是NVIDIA推理微服务(NIM),黄仁勋将其描述为“接收和打包软件的新方式”。

NVIDIA 的 NIM是包含运行生成式 AI 所需的 API、领域特定代码、优化的推理引擎和企业运行时的微服务。这些云原生微服务可以根据客户使用的 GPU 数量进行优化,并且可以在云中或自有数据中心中运行。NIM 让开发人员可以在一个软件包中使用 API、NVIDIA CUDA 和 Kubernetes。

查看:Python 仍然存在最流行的编程语言根据 TIOBE 指数。(TechRepublic)

NIM 利用 AI 构建 AI,简化构建聊天机器人所需的一些繁重工作,例如推理和训练。通过特定领域的 CUDA 库,NIM 可以根据医疗保健等高度特定的行业进行定制。

黄仁勋表示,开发人员不需要编写代码来编程人工智能,而是可以“组建一个人工智能团队”来处理 NIM 内部的流程。

黄仁勋表示:“我们想要打造聊天机器人——人工智能副驾驶——与我们的设计师一起工作。”

NIM 将于 3 月 18 日开始发售。开发人员可以免费试用 NIM,并通过 NVIDIA AI Enterprise 5.0 订阅运行它们。NIM 可在 Amazon SageMaker、Google Kubernetes Engine 和 Microsoft Azure AI 中使用,并且可以与 AI 框架 Deepset、LangChain 和 LlamaIndex 进行互操作。

NVIDIA AI Enterprise 5.0 版发布新工具

NVIDIA 推出了 AI Enterprise 5.0 版,这是其 AI 部署平台,旨在帮助组织向其客户部署生成式 AI 产品。NVIDIA AI Enterprise 5.0 版增加了以下内容:

- 国家记忆体 (NIM)。

- CUDA-X 微服务适用于各种 GPU 加速 AI 用例。

- AI Workbench,一个开发人员工具包。

- 支持 Red Hat OpenStack 平台。

- 扩展对新 NVIDIA GPU、网络硬件和虚拟化软件的支持。

NVIDIA 的检索增强生成大型语言模型运算符目前正处于 AI Enterprise 5.0 的早期访问阶段。

AI Enterprise 5.0 可通过思科、戴尔科技、惠普、HPE、联想、Supermicro 和其他提供商获得。

NVIDIA 在 GTC 2024 上发布的其他重要公告

黄仁勋在 NVIDIA GTC 2024 主题演讲中宣布了涵盖加速计算和生成式 AI 领域的一系列新产品和服务。

NVIDIA 宣布推出 cuPQC,这是一个用于加速后量子密码学的库。从事后量子密码学的开发人员可以联系 NVIDIA 了解可用性更新。

NVIDIA 的 X800 系列网络交换机加速了 AI 基础设施。具体来说,X800 系列包含 NVIDIA Quantum-X800 InfiniBand 或 NVIDIA Spectrum-X800 以太网交换机、NVIDIA Quantum Q3400 交换机和 NVIDIA ConnectXR-8 SuperNIC。X800 交换机将于 2025 年上市。

NVIDIA 主题演讲中详述的主要合作伙伴关系包括:

- NVIDIA 的全栈 AI 平台将于 3 月 18 日起登陆 Oracle 的企业 AI。

- AWS 将提供基于 NVIDIA Grace Blackwell GPU 的 Amazon EC2 实例和具有 Blackwell 安全性的 NVIDIA DGX Cloud 的访问权限。

- NVIDIA 将通过 NVIDIA Grace Blackwell AI 计算平台和 NVIDIA DGX Cloud 服务加速 Google Cloud 的发展。Google 尚未确定上市日期,但很可能是在 2024 年底。此外,自 3 月 18 日起,搭载 NVIDIA H100 的 DGX Cloud 平台已在 Google Cloud 上正式推出。

- Oracle 将在其 OCI Supercluster、OCI Compute 和 Oracle Cloud Infrastructure 上的 NVIDIA DGX Cloud 中使用 NVIDIA Grace Blackwell。Oracle-NVIDIA 联合推出自主 AI 服务自 3 月 18 日起上市。

- 微软将采用 NVIDIA Grace Blackwell 超级芯片来加速 Azure。预计将于 2024 年晚些时候上市。

- 戴尔将利用 NVIDIA 的 AI 基础设施和软件套件来打造端到端的 AI 企业解决方案 Dell AI Factory,该解决方案将于 3 月 18 日起通过传统渠道和 Dell APEX 上市。未来某个未公开的时间,戴尔将使用 NVIDIA Grace Blackwell 超级芯片作为机架规模、高密度、液冷架构的基础。该超级芯片将与戴尔的 PowerEdge 服务器兼容。

- SAP 将在其 Joule copilot 中添加 NVIDIA 检索增强生成功能。此外,SAP 将使用 NVIDIA NIM 和其他联合服务。

黄先生说:“整个行业都在为布莱克威尔做准备。”

NVIDIA AI 芯片的竞争对手

在提供企业 AI 方面,NVIDIA 主要与 AMD 和英特尔竞争。在生成式 AI 推理和训练方面,高通、SambaNova、Groq 和各种云服务提供商都在同一领域展开竞争。

AWS 拥有其专有的推理和训练平台:Inferentia 和 Trainium。除了与 NVIDIA 合作开发各种产品外,微软还拥有自己的 AI 训练和推理芯片:Azure 中的 Maia 100 AI 加速器。

免责声明:NVIDIA 支付了我参加 3 月 18 日至 21 日在加利福尼亚州圣何塞举行的 NVIDIA GTC 活动的机票、住宿和部分餐费。